如何看待ChatGPT的出現(xiàn)?ChatGPT會(huì)帶來哪些啟示

最近,ChatGPT熱潮席卷全球。

ChatGPT(Chat Generative Pre-trained Transformer)是由OpenAI于2022年12月推出的對(duì)話AI模型,僅發(fā)布2個(gè)月便實(shí)現(xiàn)月活突破1億,成為歷史上用戶增長最快的消費(fèi)級(jí)應(yīng)用之一。

圖來來源:紐約時(shí)報(bào)

ChatGPT火出圈背后是“人類反饋強(qiáng)化模型”的應(yīng)用。在問答模式的基礎(chǔ)上,ChatGPT可以進(jìn)行推理、編寫代碼、文本創(chuàng)作等等,這樣的特殊優(yōu)勢(shì)和用戶體驗(yàn)使得應(yīng)用場(chǎng)景流量大幅增加。

隨著ChatGPT用戶數(shù)快速增長,需求量火爆引發(fā)宕機(jī)。在龐大用戶群涌入的情況下,ChatGPT服務(wù)器2天宕機(jī)5次,火爆程度引人注目的同時(shí)也催生了對(duì)算力基礎(chǔ)設(shè)施建設(shè)更高的要求,特別是底層芯片。那么,ChatGPT將帶動(dòng)哪些芯片的需求?

AI服務(wù)器需求激增

當(dāng)前,ChatGPT在問答模式的基礎(chǔ)上進(jìn)行推理、編寫代碼、文本創(chuàng)作等,用戶人數(shù)及使用次數(shù)均提升,同時(shí)在一些新應(yīng)用場(chǎng)景也產(chǎn)生了較大的流量,比如智能音箱、內(nèi)容生產(chǎn)、游戲NPC、陪伴機(jī)器人等。隨著終端用戶使用頻率提高,數(shù)據(jù)流量暴漲,對(duì)服務(wù)器的數(shù)據(jù)處理能力、可靠性及安全性等要求相應(yīng)提升。

從技術(shù)原理來看,ChatGPT基于Transformer技術(shù),隨著模型不斷迭代,層數(shù)也越來越多,對(duì)算力的需求也就越來越大。從運(yùn)行條件來看,ChatGPT完美運(yùn)行的三個(gè)條件:訓(xùn)練數(shù)據(jù)+模型算法+算力,需要在基礎(chǔ)模型上進(jìn)行大規(guī)模預(yù)訓(xùn)練,存儲(chǔ)知識(shí)的能力來源于1750億參數(shù),需要大量算力。

資料顯示,ChatGPT是基于GPT-3.5優(yōu)化的一個(gè)模型,GPT-3.5是GPT-3.0的微調(diào)版本。OpenAI的GPT-3.0模型存儲(chǔ)知識(shí)的能力來源于1750億參數(shù),單次訓(xùn)練費(fèi)用約460萬美元,GPT-3.5在微軟AzureAI超算基礎(chǔ)設(shè)施上進(jìn)行訓(xùn)練,總算力消耗約3640PF-days(即假如每秒計(jì)算一千萬億次,需要計(jì)算3640天)。

可以說,ChatGPT拉動(dòng)了芯片產(chǎn)業(yè)量?jī)r(jià)齊升,即不僅對(duì)人工智能底層芯片數(shù)量產(chǎn)生了更大的需求,而且對(duì)底層芯片算力也提出了更高的要求,即拉動(dòng)了高端芯片的需求。據(jù)悉,采購一片英偉達(dá)頂級(jí)GPU成本為8萬元,GPU服務(wù)器成本通常超過40萬元。支撐ChatGPT的算力基礎(chǔ)設(shè)施至少需要上萬顆英偉達(dá)GPU A100,高端芯片需求的快速增加會(huì)進(jìn)一步拉高芯片均價(jià)。

隨著ChatGPT流量激增,作為算力載體的AI服務(wù)器將迎來重要發(fā)展機(jī)遇。預(yù)計(jì),全球AI服務(wù)器市場(chǎng)將從2020年的122億美元成長到2025年288億美元,年復(fù)合增長率達(dá)到18.8%。

這些芯片將受益

從芯片構(gòu)成來看,AI服務(wù)器主要是CPU+加速芯片,通常搭載GPU、FPGA、ASIC等加速芯片,利用CPU與加速芯片的組合可以滿足高吞吐量互聯(lián)的需求。

1.CPU

作為計(jì)算機(jī)系統(tǒng)的運(yùn)算和控制核心,是信息處理、程序運(yùn)行的最終執(zhí)行單元。其優(yōu)勢(shì)在于有大量的緩存和復(fù)雜的邏輯控制單元,擅長邏輯控制、串行的運(yùn)算;劣勢(shì)在于計(jì)算量較小,且不擅長復(fù)雜算法運(yùn)算和處理并行重復(fù)的操作。因此,CPU在深度學(xué)習(xí)中可用于推理/預(yù)測(cè)。

目前,服務(wù)器CPU向多核心發(fā)展,滿足處理能力和速度提升需要,比如AMD EPYC 9004核心數(shù)量最多可達(dá)96個(gè)。不過,系統(tǒng)性能優(yōu)劣不能只考慮CPU核心數(shù)量,還要考慮操作系統(tǒng)、調(diào)度算法、應(yīng)用和驅(qū)動(dòng)程序等。

2.GPU

GPU高度適配AI模型構(gòu)建,由于具備并行計(jì)算能力,可兼容訓(xùn)練和推理,目前GPU被廣泛應(yīng)用于加速芯片。以英偉達(dá)A100為例,在訓(xùn)練過程中,GPU幫助高速解決問題:2048個(gè)A100 GPU可在一分鐘內(nèi)成規(guī)模地處理 BERT之類的訓(xùn)練工作負(fù)載。在推理過程中,多實(shí)例GPU (MIG)技術(shù)允許多個(gè)網(wǎng)絡(luò)同時(shí)基于單個(gè)A100運(yùn)行,從而優(yōu)化計(jì)算資源的利用率。在A100其他推理性能增益的基礎(chǔ)之上,僅結(jié)構(gòu)稀疏支持一項(xiàng)就能帶來高達(dá)兩倍的性能提升。在BERT等先進(jìn)的對(duì)話式AI模型上,A100可將推理吞吐量提升到高達(dá)CPU的249倍。

目前,ChatGPT引發(fā)了GPU應(yīng)用熱潮。其中,百度即將推出文心一言(ERNIE Bot)。蘋果則引入AI加速器設(shè)計(jì)的M2系列芯片(M2 pro和M2 max)將被搭載于新款電腦。隨著ChatGPT的使用量激增,OpenAI需要更強(qiáng)的計(jì)算能力來響應(yīng)百萬級(jí)別的用戶需求,因此增加了對(duì)英偉達(dá)GPU的需求。

AMD計(jì)劃推出與蘋果M2系列芯片競(jìng)爭(zhēng)的臺(tái)積電4nm工藝“Phoenix”系列芯片,以及使用Chiplet工藝設(shè)計(jì)的“Alveo V70”AI芯片。這兩款芯片均計(jì)劃在今年推向市場(chǎng),分別面向消費(fèi)電子市場(chǎng)以及AI推理領(lǐng)域。

3.FPGA

FPGA具有可編程靈活性高、開發(fā)周期短、現(xiàn)場(chǎng)可重編功能、低延時(shí)、方便并行計(jì)算等特點(diǎn),可通過深度學(xué)習(xí)+分布集群數(shù)據(jù)傳輸賦能大模型。

4.ASIC

ASIC在批量生產(chǎn)時(shí)與通用集成電路相比具有體積更小、功耗更低、可靠性提高、性能提高、保密性增強(qiáng)、成本降低等優(yōu)點(diǎn),可進(jìn)一步優(yōu)化性能與功耗。隨著機(jī)器學(xué)習(xí)、邊緣計(jì)算、自動(dòng)駕駛的發(fā)展,大量數(shù)據(jù)處理任務(wù)的產(chǎn)生,對(duì)于芯片計(jì)算效率、計(jì)算能力和計(jì)能耗比的要求也越來越高,ASIC通過與CPU結(jié)合的方式被廣泛關(guān)注,國內(nèi)外龍頭廠商紛紛布局迎戰(zhàn)AI時(shí)代的到來。

其中,谷歌最新的TPU v4集群被稱為Pod,包含4096個(gè)v4芯片,可提供超過1 exaflops的浮點(diǎn)性能。英偉達(dá)GPU+CUDA主要面向大型數(shù)據(jù)密集型HPC和AI應(yīng)用;基于Grace的系統(tǒng)與NVIDIAGPU緊密結(jié)合,性能比NVIDIADGX系統(tǒng)高出10倍。百度昆侖2代AI芯片采用全球領(lǐng)先的7nm 制程,搭載自研的第二代 XPU 架構(gòu),相比一代性能提升2-3倍;昆侖芯3代將于2024年初量產(chǎn)。

5.光模塊

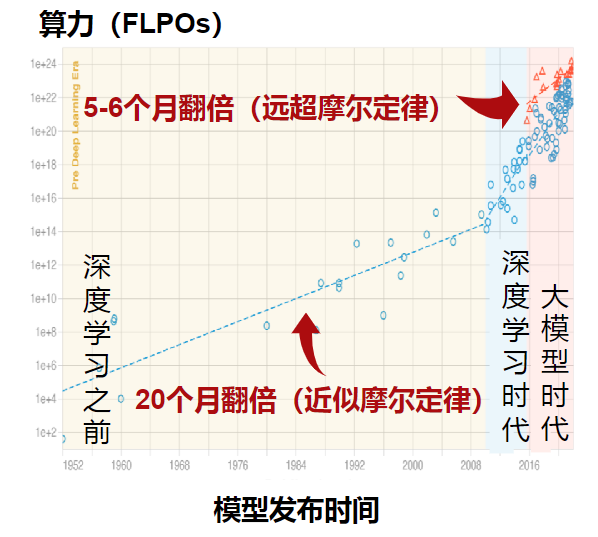

當(dāng)前,AI時(shí)代模型算力需求已經(jīng)遠(yuǎn)超摩爾定律的速度增長,特別是在深度學(xué)習(xí)、大模型時(shí)代之后,預(yù)計(jì)5-6個(gè)月翻倍。然而,數(shù)據(jù)傳輸速率成為容易被忽略的算力瓶頸。伴隨數(shù)據(jù)傳輸量的增長,光模塊作為數(shù)據(jù)中心內(nèi)設(shè)備互聯(lián)的載體,需求量隨之增長。

來源:Google Scholar

未來算力升級(jí)路徑

最近,ChatGPT的興起推動(dòng)著人工智能在應(yīng)用端的蓬勃發(fā)展,這也對(duì)計(jì)算設(shè)備的運(yùn)算能力提出了前所未有的需求。雖然AI芯片、GPU、CPU+FPGA等芯片已經(jīng)對(duì)現(xiàn)有模型構(gòu)成底層算力支撐,但面對(duì)未來潛在的算力指數(shù)增長,短期使用Chiplet異構(gòu)技術(shù)加速各類應(yīng)用算法落地,長期來看打造存算一體芯片(減少芯片內(nèi)外的數(shù)據(jù)搬運(yùn)),或?qū)⒊蔀槲磥硭懔ι?jí)的潛在方式。

1. Chiplet

Chiplet是布局先進(jìn)制程、加速算力升級(jí)的關(guān)鍵技術(shù)。Chiplet異構(gòu)技術(shù)不僅可以突破先進(jìn)制程的封鎖,并且可以大幅提升大型芯片的良率、降低設(shè)計(jì)的復(fù)雜程度和設(shè)計(jì)成本、降低芯片制造成本。不過,雖然Chiplet技術(shù)加速了算力升級(jí),但需要犧牲一定的體積和功耗,因此將率先在基站、服務(wù)器、智能電車等領(lǐng)域廣泛使用。

目前,Chiplet已廣泛應(yīng)用于服務(wù)器芯片。AMD是Chiplet服務(wù)器芯片的引領(lǐng)者,其基于Chiplet的第一代AMDEPYC處理器中,裝載8個(gè)“Zen”CPU核,2個(gè)DDR4內(nèi)存通道和32個(gè)PCIe通道。2022年AMD正式發(fā)布第四代EPYC處理器,擁有高達(dá)96顆5nm的Zen4核心,并使用新一代的Chiplet工藝,結(jié)合5nm和6nm工藝來降低成本。

英特爾第14代酷睿Meteor Lake首次采用intel 4工藝,首次引入Chiplet小芯片設(shè)計(jì),預(yù)計(jì)將于2023年下半年推出,至少性能功耗比的目標(biāo)要達(dá)到13代 Raptor Lake的1.5倍水平。

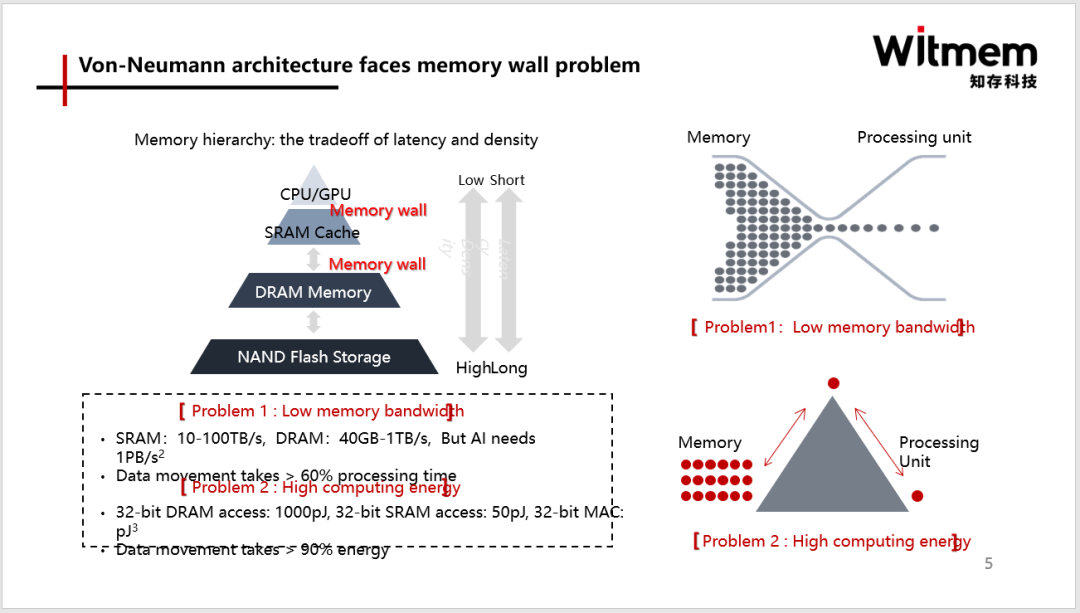

2.存算一體

正如上文提到的,AI時(shí)代模型算力需求遠(yuǎn)超摩爾定律的速度增長,單純靠縮微化制程已經(jīng)無法滿足需求而且成本急速攀升。實(shí)際上,從現(xiàn)有芯片架構(gòu)來看,超過60%時(shí)間是花在數(shù)據(jù)搬運(yùn)上,超過90%的功耗也損失在數(shù)據(jù)搬運(yùn)上,能效非常低。因此,存儲(chǔ)墻”成為了數(shù)據(jù)計(jì)算應(yīng)用的一大障礙。而存算一體是算力需求上升的主要解決技術(shù)路線之一。

存內(nèi)計(jì)算的計(jì)算原理可以理解成是用存儲(chǔ)器做計(jì)算,其計(jì)算單元不再是邏輯器件、CPU、GPU或者NPU,與這些架構(gòu)是完全不一樣的。存內(nèi)計(jì)算直接運(yùn)算單元是存儲(chǔ)單元本身。存算一體技術(shù)通過在存儲(chǔ)器中疊加計(jì)算能力,以新的高效運(yùn)算架構(gòu)進(jìn)行二維和三維矩陣運(yùn)算。